BIGLOBEクラウドホスティングを少し触ってみた感想

すごくひさしぶりの更新です。プロジェクトに忙殺されていました。

よくないですね。これからまた更新頻度をあげていきたいと思います。

さて、今日はBIGLOBEクラウドホスティングを使ってみたのでそのことを書いてみようと思います。サービスのサイトは以下です。

http://business.biglobe.ne.jp/hosting/cloud/

使い方は以下のページに載っていて、イメージしやすいです。

http://www.atmarkit.co.jp/ad/nec_biglobe/biglobe_cloud.html

私自身はAWSを使ったサイト構築や受託での提案などの経験があり、

普段AWSを愛用しているものですが、そういった立場で試用して

みた感想(なるべくよいところ)を書いてみようと思います。

■ サービス概要と最初の印象

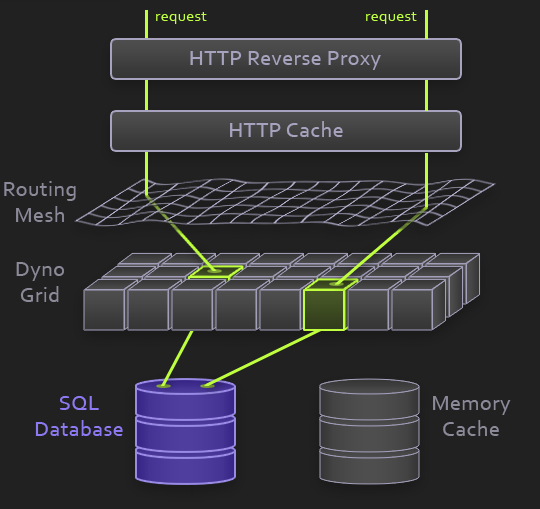

クラウドサービスの分類としてはIaaSに入ります。Amazon EC2と同じく、コントロールパネルからサーバの起動や停止ができます。鍵ペアを発行してログインに至るまでのプロセスなどはEC2を使っている人はなじみがあるプロセスかと思います。

サービスはEC2と同じくサーバリソースの提供がメインです。CentOS、RHEL、Windows系が

サポートされており、EC2を激しく意識しているらしいので、価格帯はEC2と勝負できる範囲です。Reserved Instanceに相当するものが今のところ用意されていなさそうなのは、価格面では

ちょっと残念なことろでしょうか。(もちろん、今後に期待!)

DB等のミドルウェア系のサービスは今のところあまりありませんが、きっとこれから提供されていくのだと思います。あ、DBサーバにMySQLを初期インストールするといったショートカットするオプションはあります。

サーバイメージの保存、ロードバランサ、監視サービスなどは提供されています。

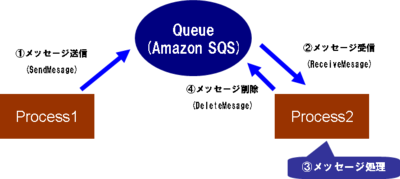

ただ、AWSと比較するとS3、SimpleDB、SNS、SQS、SES・・・といったAWSを彩る魅力的なサービス群に該当するものはなさそうです。(一部は連携メニューにあるかもです)

■ セキュリティサービスがあるのが一番の特徴(だと思う)

ここまでは始ったばかりのサービスでもあるからか、あまり大きな特徴がないようにも見えますが、一点、目を見張るサービスがありました。セキュリティオプションのWAF(Web Application Firewall)です。(あ、サーバ稼働率99.99%のサービスレベルの保証は「おっ」とは思いました)

最近は個人情報漏洩などの問題もあり、セキュリティ系だけはきっちり、という要望が私の知る範囲では多く見られます。セキュリティをがっちり、というのはたしかに大事なのですが、WAFやIDSなどはそれを主業務としない立場としては、構築、運用にけっこう手間がかかってしまうというジレンマがあります。

構築するのもアプリ開発とは違う知識が必要ですし、構築後も「検知ルールの運用どうするんだぁ?」とかとか、いろいろ大変です。

AWSで自分がログ等を監査できるWAFやIDSをきっちりやろうとすると、今のところは自前で構築が必要になります。(IDSは程度にもよりますが、ネットワーク型のものは自前では構築は明らかに困難・・・、)

実際の私の経験でもWAFやIDSの設置(設置した場合の運用コスト)がネックのひとつと

なりAWSを提案したけど、見送られたというケースがありました。

そういったことを踏まえたとき、WAFが最初から選択可能なサービスとして提供されているのはすごくうれしい限りです。さっとサービスを立ち上げたいけど、WAFを設置したい、ってのを両立できそうです。

IDSに関してはコントロールパネルから利用可能な形ではなく、連携メニューとしてホームページに掲載がある程度ですが、そういうものをちゃんと用意してきてくれているのがすごく個人的にはよいなと思いました。

こういったセキュリティ系のサービスをなるべく拡充して、使い勝手よくローコストで提供していってほしいな、と思いました。

■ あと、細かいかもしれませんが、用語が馴染みやすい

今のところシンプルなコントロールパネルですが、AWSとの比較で考えると、対エンジニアはともかくとしてそうではない人にたいして、言葉が簡単でよいな、と思いました。

AWSについて打ち合わせなどをするとS3、ELB、RDS、EC2・・・、という短縮語が飛び交い、慣れている人はよいですが、そうではない人に対して「S3ってのはね・・・」「EC2ってのはね・・・」と説明しなくてはいけないケースがときどきありました。

(これは、職場環境やどういったお客様と接しているか、という環境にもよるのであくまでも私のケースですが)

BIGLOBEのはサーバ作成、サーバ一覧、ディスク追加、といった用語がコントロールパネル上を埋めており、「あー、まあ、たしかに分かりやすいよね」と思いました。

AWSのS3とか使わない人にはとっつきやすいかもしれません。

■ 当社にとってSIerとしての使いどころ

当社は自社サービスでAWSを使っており、S3など気に入って使っているので個人的には自社開発のものはやはり引き続きAWSを使おうかなぁ、と思っています。

また、当社はSalesforceとのインテグレーション事業を一所懸命やっていますが、Salesforceとの連携においてEC2というよりはS3などのAWSのコンポーネント群とのインテグレーションはノウハウを引き続き活用していきたいと思っています。

ただ、WEBサイト開発などの受託開発という面においては必ずしもS3とかAWSのコンポーネント群を必要としないお客様も多く、またセキュリティ要件が一層厳しくなりつつある状況なので、

そういったお客様に対してはWAFやIDS連携ができるといったメリットが大きく効いてくる可能性が高いと考えています。そういったお客様は少なくないので、ひとつの有力な選択肢として準備しておきたいな、と思いました。

■ 今後について

現在、BIGLOBEクラウドホスティングをひとつの選択肢にしようと、一部の自社内システムリソースの移行を検証しており、おそらく夏中には実運用することになると思います。AWSの知見を引き続き自社サービスで蓄えつつ、セキュリティに強い方の選択肢としてBIGLOBEクラウドホスティングの知見をこれから社内でためていこうと思います。

その上で、ニーズに応じて必要なプラットフォームを選択できる体制を社内に築いていくつもりです。

また、新しいサービス等、追加されたら試してブログ書いてみます。

のSalesforce/Force.com

のSalesforce/Force.com